Der schmale Grat zwischen Innovation und Halluzination

Was Large Language Models wirklich können

Laura Bies, Oliver Müller, Tim Grundtner und Dirk Werth, August-Wilhelm Scheer Institut

(Titelbild: © Adobe Stock | 856989061| Orxan)

Kurz und Bündig

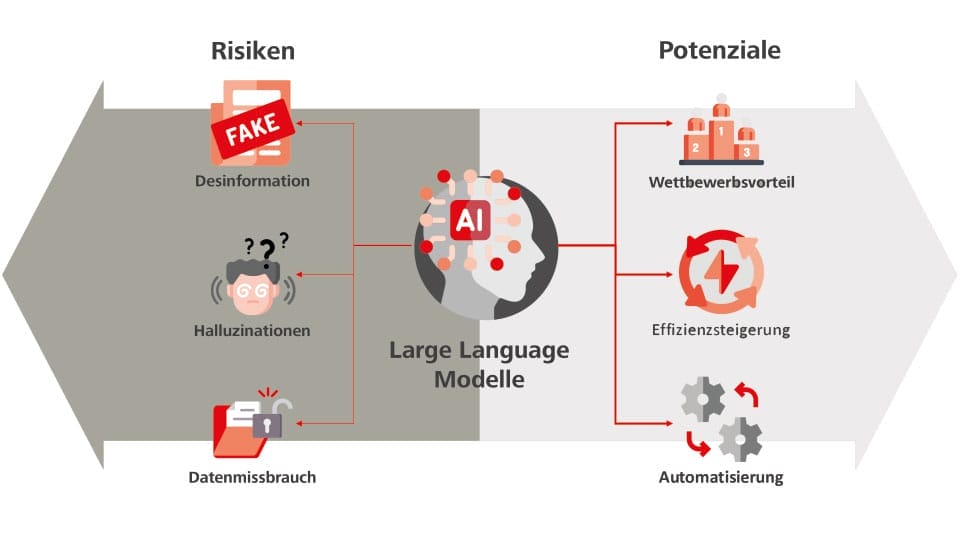

Die ordnungsgemäße Nutzung von LLMs kann die Innovationskraft eines Unternehmens erheblich steigern. Es ist jedoch wichtig, sich der Schwächen und Risiken von LLMs bewusst zu sein. Denn die Entwicklung und Regulierung generativer KI steckt noch in den Anfängen, und die Zukunft verspricht spannende Möglichkeiten für Unternehmen und Einzelpersonen.

In den letzten Jahren haben Large Language Models (LLMs) wie GPT-4 enorme Fortschritte gemacht, was bereits zu einem tiefgreifenden Wandel in vielen Branchen und der öffentlichen Wahrnehmung geführt hat. Diese Technologien bieten insbesondere für den Mittelstand zahlreiche Anwendungsmöglichkeiten. Sie bergen andererseits aber auch Gefahren, die es im Sinne einer effektiven Nutzung zu identifizieren und beheben gilt.

Der verantwortungsvolle Einsatz der KI-Technologie erfordert klare Richtlinien und Best Practices, um Missbrauch zu verhindern und die Privatsphäre der Nutzenden zu schützen [1]. Darüber hinaus ist es unabdingbar, ein allgemeines Bewusstsein für die Stärken und Schwächen von LLMs zu schaffen, um die Mitarbeitenden in kleinen und mittelständischen Unternehmen dafür zu sensibilisieren, in welchen Bereichen diese Modelle sinnvoll eingesetzt werden und wie sie sie effektiv zu ihrem Vorteil nutzen können.

Schwächen und Gefahren von LLMs und ihre Mitigation

Während immer mehr Unternehmen das große Potenzial von LLMs, wie ChatGPT und seinen größten Konkurrenten Google Gemini (vormals Bard), Microsoft Copilot oder Claude (Anthropic) erkennen, fehlt es den Mitarbeitenden oftmals noch an der sogenannten AI-Literacy. Konkret umschreibt es die Fähigkeit, künstliche Intelligenz zu verstehen und die Technologien und Modelle effektiv nutzen und in den Alltag integrieren zu können. Dies ermöglicht die Identifikation relevanter Anwendungsfälle und die Umsetzung innovativer KI-Projekte, die effektiv auf die Bedürfnisse des Unternehmens eingehen und die Potenziale der Modelle ausschöpfen [2]. Mangelnde AI-Literacy bei der Verwendung von LLMs führt jedoch nicht nur zu einem Verlust an Effizienz und Qualität der Ergebnisse, sondern kann im schlimmsten Fall auch halluzinierte Inhalte schaffen.

Generative KI und insbesondere Modelle wie ChatGPT, die auf der Transformer-Architektur basieren, haben eine ausgesprochen starke Neigung zu Halluzinationen und Fehlbarkeit. Halluzinierte Inhalte sind Ausgaben eines LLMs, die nicht wahrheitsgetreu sind, aber überzeugend erscheinen. Dadurch können sie Verwirrung, Desinformation oder Fehler bei der Weiterverwendung verursachen [3]. Einerseits können sachlich falsche Behauptungen aufgestellt werden. Ein Beispiel hierfür ist, dass laut einem LLM Thomas Edison das Telefon erfunden hat, woraufhin das Modell detailliert über die nicht existierenden Experimente berichtete. Andererseits können auch völlig neue Tatsachen geschaffen werden, zum Beispiel ein fiktives historisches Ereignis wie ein Krieg zwischen zwei Ländern, der nie stattgefunden hat. Die letzte Variante von Halluzinationen entsteht durch unzureichende Kontextualisierung aus, wenn beispielsweise vom „letzten Präsidenten“ gesprochen wird, ohne zu spezifizieren, von welchem Land oder Zeitpunkt die Rede ist.

Gravierende Folgen können dann auftreten, wenn fehlerhafte Ergebnisse ungeprüft und ungefiltert weitergegeben oder in die Unternehmensprozesse integriert werden. Da ein solches Szenario jedoch grundsätzlich nicht wünschenswert ist, ist die Kenntnis von Methoden zur Vermeidung beziehungsweise Reduzierung von Halluzinationen von hoher Relevanz. Dazu ist es zunächst nötig, die Ursachen und verstärkenden Faktoren zu verstehen. Zu diesen gehören fehlendes Fachwissen oder „Knowledge-Cutoffs“ in den Trainingsdaten der Modelle, die Tendenz von LLMs zum „People Pleasing“, ein zu umfangreiches Kontextfenster oder ein schlecht formulierter Prompt. Für die breite Mehrheit der Anwendenden sind hiervon nur die letzten beiden Gründe relevant, da die Probleme von fehlendem Fachwissen und des People Pleasings in der Regel durch die zugrunde liegenden Modelle und deren Trainingsdaten verursacht werden. Um das Problem eines überfüllten Kontextfensters in einem Chat zu lösen, kann einfach für jedes neue Thema ein neuer Chat gestartet werden. Mit der Einführung der „Memory-Funktion“ in ChatGPT wird es zukünftig auch nicht mehr notwendig sein, einen Chat über längere Zeiträume hinweg aufgrund des Kontextwissens zu verwenden.

Der zweite Fall bezieht sich auf die Fähigkeit des „Prompt-Engineering“, also die Fähigkeit, durch effizient formulierte Prompts den bestmöglichen Output in möglichst wenigen Anfragen zu erzeugen. Die größere Gefahr liegt in diesen Fällen jedoch in der potenziell halluzinierten Ausgabe, die unter anderem durch zweideutige, schlecht formulierte oder falsche Prompts verursacht werden kann. LLMs haben zudem eine bedeutende Schwäche bei der Überprüfung von Fakten und der Verifizierung von Informationen. Obwohl die Modelle neben ihren Trainingsdaten auch Echtzeitrecherchen im Internet durchführen können, bleibt die Tatsache bestehen, dass ihre Systemarchitektur nach wie vor auf fehlbaren Wahrscheinlichkeitsmodellen basiert, selbst wenn sie aktuellere Informationen verwenden. Aus diesem Grund sind sie für Anwendungsfälle wie eine adäquate Dokumentenprüfung durch Informations- und Quellenextraktion noch nicht geeignet beziehungsweise keine allein ausreichende Lösung.

Im Hinblick auf die aktive Vermeidung von Halluzinationen bei großen Sprachmodellen (LLMs) haben sich Retrieval-Augmented Generation (RAG) Ansätze als eine effektive Methode erwiesen, um die Robustheit der generierten Ausgaben zu erhöhen [5]. Zusätzlich zu ihren begrenzten Trainingsdaten erhalten die Modelle Zugriff auf externe Ressourcen wie faktenbasierte Datenbanken, die außerhalb ihres trainierten Wissensspeichers liegen. Dadurch können sie ihre Schlussfolgerungen mit einer externen Quelle abgleichen und so bessere Ergebnisse erzielen. Dies betrifft insbesondere die „Noise Robustness“, also die Fähigkeit, Fehler in den relevanten Dokumenten zu erkennen und nur die korrekten Informationen zu extrahieren. Ein Beispiel dafür wäre, wenn nach dem Gewinner des Nobelpreises für Literatur im Jahr 2022 gefragt wird und die Dokumente auch Informationen über den Gewinner von 2021 enthalten. In diesem Fall kann das Sprachmodell die widersprüchlichen Informationen korrekt auseinanderhalten und die richtige Antwort liefern [3].

Darüber hinaus sind LLMs anfällig für die Verstärkung von Biases, Risiken für die Privatsphäre und böswillige Ausnutzung für die Erzeugung von Desinformation, Deep Fakes und anderen verbotenen Inhalten. Biases können aus verschiedenen Quellen stammen. Sie können aus den Trainingsdaten selbst entstehen, wenn bestimmte Inhalte oder Gruppen unter- oder überrepräsentiert sind. Sie können auch absichtlich von den Entwickler:innen implementiert werden oder systeminhärent sein, also aus bestimmten Eigenschaften der Software resultieren [6]. Aus datenschutzrechtlicher Sicht sollten in öffentliche Sprachmodelle niemals private, persönliche oder vertrauliche Firmendaten eingegeben werden. In vielen Fällen kann keine absolute Datensicherheit gewährleistet werden, beziehungsweise müssen dem Anwender die verfügbaren Datenschutzoptionen bekannt sein und berücksichtigt werden. Im Unternehmensumfeld sind problematische Szenarien leicht vorstellbar, in denen unbeabsichtigte Fehlinformationen in den Arbeitsprozessen eines KMU eine Kettenreaktion mit gravierenden negativen Folgen auslösen können. Es ist daher äußerst wichtig, die Mitarbeitenden durch Schulungen und Workshops sowohl für diese Schwachstellen zu sensibilisieren als auch in der effektiven Nutzung von LLMs zu trainieren. Ebenso muss auf die ethische Seite der Nutzung dieser Modelle hingewiesen und ein kritischer Umgang mit KI-generierten Inhalten, die potenziell bösartige oder verbotene Inhalte enthalten können, gefördert werden [1].

Stärken und Potenziale von LLMs

Neben der Bedeutung von AI-Literacy und den mit großen Sprachmodellen verbundenen Risiken von Halluzinationen, Verzerrungen und Datenschutz ist das Potenzial der Technologie unumstritten. Doch worin genau liegen die konkreten Stärken und Potenziale von Sprachmodellen, und welche weiteren Entwicklungen sind in Zukunft zu erwarten?

LLMs bieten Unternehmen die Möglichkeit, ihre Effizienz, Kreativität und den Automatisierungsgrad enorm zu steigern. Sprachmodelle können Aufgaben automatisieren, bei der Erstellung von Inhalten unterstützen und personalisierte Lösungen anbieten. Mittels Natural Language Processing (NLP), also der Fähigkeit, natürliche Sprache zu verstehen, sind LLMs außerdem dazu in der Lage, die Kommunikation in Unternehmen intern sowie extern zu verbessern. Eines der wichtigsten Merkmale von LLMs ist wahrscheinlich ihre Fähigkeit, kreative Ideen zu entwickeln und Inhalte und hochwertige Texte für eine Vielzahl von Anwendungsfällen zu erstellen. Des Weiteren können LLMs zur Effizienzsteigerung innerhalb einer Organisation beitragen, indem sie repetitive Aufgaben automatisieren und somit den gesamten Arbeitsablauf beschleunigen. Dies führt zu einer signifikanten Zeit- und Kostenersparnis und ermöglicht es den Mitarbeitenden, sich auf strategischere und komplexere Aufgaben zu fokussieren.

Konkrete Use Cases sind beispielhaft die Erstellung von Content, von Marketingtexten bis hin zur Generierung von Schulungsmaterialien. Zudem können LLMs komplette Marketingprozesse optimieren, indem sie den Prozess von der Recherche SEO-relevanter Keywords bis hin zur Wettbewerbsanalyse und der Generierung SEO-optimierten Produktbeschreibungen begleiten. Viele solcher Anwendungsfälle lassen sich oft schon mit direkt einsatzbereiten LLMs wie ChatGPT bewältigen. Allerdings sind diese Modelle nicht immer spezifisch genug für den jeweiligen Anwendungsfall. Eine Möglichkeit bietet die Erstellung eines Custom GPTs, das genau auf einen bestimmten Use Case zugeschnitten ist. Dieses spezielle GPT kann auf Basis des bestehenden Modells angepasst und trainiert werden, um spezifische Anforderungen und Szenarien abzudecken. Eine umfangreichere Möglichkeit besteht darin, ein unternehmenseigenes LLM zu erstellen, das heißt, ein Modell wird auf der eigenen IT-Infrastruktur implementiert. Obwohl dies vielversprechend klingt, ist es für die meisten KMUs oft nicht realisierbar, da es mit einem hohen Aufwand, hohen Kosten und einem erheblichen Zeitaufwand einhergeht und viel technisches Know-how erfordert. Alternativ können vortrainierte Modelle von Anbietern wie OpenAI mithilfe einer kostenpflichtigen Developer API feinjustiert und so auf ein Unternehmen oder einen speziellen Anwendungsfall angepasst werden. Diese Methode bietet eine kosteneffiziente und zugängliche Lösung, um die Vorteile dieser revolutionären Technologie voll auszuschöpfen.

Mit Blick auf die Zukunft wird vermutlich für jede automatisierbare Aufgabe eine individuell angepasste Version eines LLM existieren, die diese Aufgabe effizient erledigen kann. Man geht davon aus, dass LLMs zunehmend besser darin werden, spezifisches Fachwissen zu integrieren, um in spezialisierten Bereichen wie Medizin, Recht und Technik noch präzisere und nützlichere Antworten zu liefern. Fortschritte wie diese könnten die Art und Weise, wie Unternehmen KI-Modelle nutzen, revolutionieren und völlig neue Möglichkeiten zur Optimierung von Geschäftsprozessen eröffnen.