„Das hätte man wissen

können!“

Echtzeit-Datenanalyse als Gefahrenmelder

Georg Wittenburg, Inspirent GmbH

Kurz & Bündig

Die Datenströme eines Autos werden in Echtzeit ausgewertet, um bei entsprechenden Gefahrensituationen den Fahrer zu warnen oder sogar aktiv ins Fahrgeschehen einzugreifen. Eine solche Echtzeitauswertung der Datenströme in Unternehmen würde deren Resilienz gegen Betrug und Krisen deutlich erhöhen.

Unternehmen sind wie Autos – nur, dass moderne Autos den Fahrer mit einem Piepen warnen, bevor es zu einem Blechschaden kommt. Unternehmen und Autos bewegen sich durch eine Datenwolke. Für ein Auto sind dies interne Datenströme vom Motor und der Bremsanlage sowie externe Daten vom GPS, aus den Abstandssensoren, aus Kameras oder sogar einem Lidar-System. Ganz analog dazu verhält es sich bei Firmen: Sie bewegen sich durch eine Datenwolke aus internen Finanzdaten und operativen Kennzahlen sowie aus externen Marktdaten, Forecasts und Social-MediaTrends. Genutzt werden diese Datenströme jedoch ganz unterschiedlich.

Die Datenströme eines Autos werden in Echtzeit ausgewertet, um bei entsprechenden Gefahrensituationen den Fahrer entweder zu warnen oder sogar aktiv ins Fahrgeschehen einzugreifen, z.B. durch eine Notbremsung. Bei Unternehmen hingegen steht oftmals die Datenhaltung im Vordergrund: Datenströme werden bereinigt, konsolidiert und in einem Data Warehouse oder einem Data Lake gelagert. Teile dieser Daten werden auch analysiert und visuell aufbereitet.

Als Status quo lässt sich also festhalten, dass…

1. sowohl Unternehmen als auch Autos sich durch Datenwolken bewegen,

2. Unternehmen mehr Daten zur Verfügung haben als Autos,

3. moderne Autos einen höheren Nutzungsgrad ihrer Daten erreichen,

4. die Datennutzung in Unternehmen häufig in Dashboards endet, während moderne Autos anfangen, autonom auf ihre Datenströme zu agieren.

Der Vergleich zwischen Unternehmen und Autos bezüglich ihres jeweiligen Datennutzungsgrades erscheint hier fast schon unfair zu werden – und jeder, der einmal ein Enterprise Data Warehouse eingeführt hat, wird dies bestätigen wollen.

Die Versuchung ist groß, sich mit dem beschriebenen Status quo zu arrangieren. Folglich wäre zu akzeptieren, dass es für Unternehmen und deren Stakeholder Risiken gibt, die zwar Spuren in den Geschäftsdaten hinterlassen, aber trotzdem unerkannt bleiben. Doch dies ist unbefriedigend, nicht zuletzt aufgrund der finanziellen Schäden, die durch diese Form der Datenblindheit entstehen können:

• Das New Yorker Department of Financial Services verhängte im Juli 2020 eine Strafe von 150 Millionen US-Dollar gegen die Deutsche Bank AG aufgrund mangelhafter Geldwäschekontrollen, z.B. im Fall Jeffrey Epstein.

• Durch die Implosion der Wirecard AG im Juni 2020 wurden 24 Milliarden Euro Börsenwert vernichtet, während sich im Nachhinein zur Überraschung von Wirtschaftsprüfern und Regulatoren herausstellte, dass ein Großteil des Asiengeschäfts erfunden war.

• Im Dieselskandal verhängte die Staatsanwaltschaft Stuttgart gegen die Daimler AG im September 2019 ein Bußgeld von 870 Millionen Euro, während die Volkswagen AG im gleichen Zusammenhang schon 2016 Rückstellungen von 16,2 Milliarden Euro bilden musste.

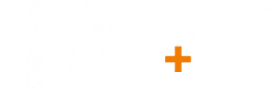

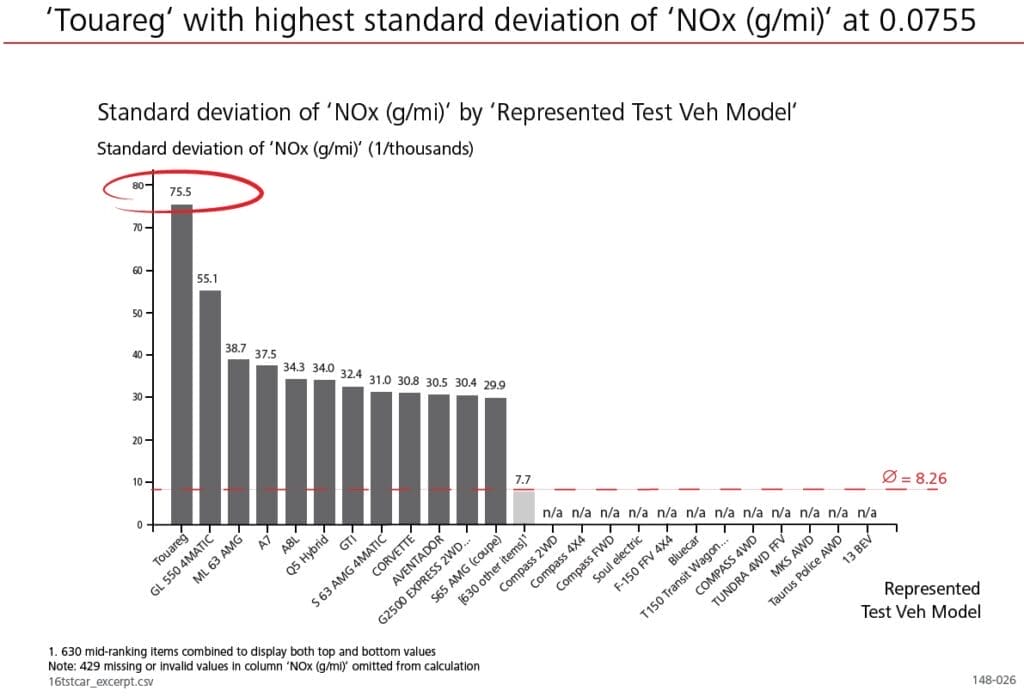

Der letzte dieser drei Fälle ist besonders interessant, da man sich hier selbst einen Eindruck von der Qualität des Datennebels verschaffen kann: Die US-amerikanische Umweltbehörde EPA stellt die von ihr gemessenen Abgaswerte jedes Jahr online frei zur Verfügung. Und hier sind, wie in Abbildung 1 dargestellt, die Datenspuren des Betrugs klar erkennbar.

Angesichts dieser Spuren in den verfügbaren Daten im Falle des Dieselskandals liegt die Frage nahe, welche Spuren es in den zwei anderen Fällen vielleicht auch gegeben haben könnte. Wären diese Skandale vielleicht gar durch bessere Datenauswertung vermeidbar gewesen? Das New Yorker Department of Financial Services meint im Falle der Deutschen Bank hierzu: „The Bank’s fundamental failure was that, although the Bank properly classified Mr. Epstein as high-risk, the Bank failed to scrutinize the activity in the accounts for the kinds of activity that were obviously implicated by Mr. Epstein’s past“…oder auf Deutsch gesagt: „Ja, das hätte man wissen können – und müssen!“

Jeder risikoaverse Geschäftsführer müsste sich jetzt eigentlich die Frage stellen, ob angesichts dieser Beispiele der Status quo der Datenauswertung noch haltbar ist. Können tatsächlich nur Autos vor einem drohenden Blechschaden warnen, während die Verantwortlichen in Firmen auf dem Risiko sitzen bleiben? Oder konkreter gefragt: Kann sich tatsächlich nur ein Auto ein 360-Grad-Bild seiner Umgebung zum Zwecke der Risikoerkennung machen, während man in Firmen mit den Augen geradeaus stets auf die immer gleichen Kennzahlen im Dashboard schaut?

Praktiker werden hier einwerfen, dass es Autos mit ihrem Rundumblick einfach haben, während Unternehmen – angesichts der Vielzahl der Datenquellen einerseits und der Personalkosten der Datenanalysen andererseits – sich die Frage stellen müssen, in welche Richtung sie zuerst schauen sollten. Diese Frage ist in der Tat sehr legitim, denn schließlich darf man davon ausgehen, dass weder die Risikoanalysten bei der Deutschen Bank noch die Prüfer bei der Bafin, noch die Compliance-Abteilungen bei Daimler und Volkswagen Däumchen gedreht haben, während hellerleuchtete Datenmuster an ihnen vorbeihuschten.

Tatsächlich stellt die menschliche Auswertung der Daten durch Analysten und Data Scientists – auch angesichts der Investitionen in Dateninfrastruktur in den letzten Jahren – eine wesentliche Schwachstelle auf dem Weg zur risikoarmen, resilienten Unternehmensführung dar. Problematisch hierbei sind sowohl Kapazität bzw. Effizienz einer Analytik-Abteilung als auch der sogenannte Streetlight Effekt. Menschliche kognitive Ausrichtung führt dazu, dass eher nach bekannten, leicht auffindbaren Mustern in betrieblichen Daten gesucht wird statt nach dem „schwarzen Schwan“, der das Unternehmen bedrohen könnte.

Das Umschiffen von vermeidbaren Risiken erfordert also eine Steigerung des Analytikdurchsatzes eines Unternehmens, allerdings unter Vermeidung der menschlichen Tendenz, eher wohlbekannte Muster erneut zu suchen. Analog zu den selbstfahrenden Autos bietet sich auch für Unternehmen die Anwendung von Künstlicher Intelligenz (KI) an, um ihre Datenströme optimal auszuwerten. Tatsächlich ist eine autonom arbeitende Datenauswertung inzwischen technisch machbar. So wurden beispielsweise die zwei Diagramme in Abbildung 1, inkl. der Hervorhebungen und Beschriftung, durch die Inspirient Automated Analytics Engine ohne menschliches Zutun erstellt.

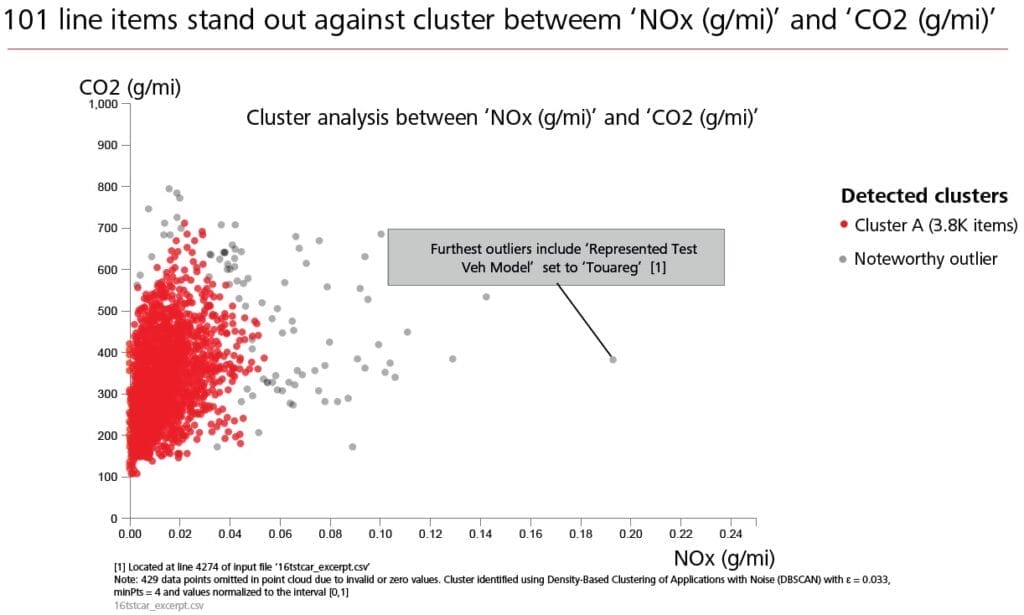

Im Einsatz zur Risikominimierung lässt sich ein solches System wie in Abbildung 2 dargestellt in bestehenden Prozesse einbinden: Betriebliche Rohdaten werden vollautomatisch auf potenzielle Risikoindikatoren, wie beispielsweise Trendveränderung oder plötzliche Häufungen von Ausreißern, untersucht. Die Ergebnisse werden priorisiert und für einen menschlichen Fachexperten graphisch und textuell aufbereitet. Der Fachexperte bewertet die möglichen Risikoindikatoren angesichts der eigenen betrieblichen und branchenspezifischen Erfahrung. Mittels Feedback-Schleife werden diese Bewertungen in den Risikosensor eingespielt, der dadurch immer besser darin wird zu unterscheiden, welches Datenmuster ein tatsächliches Risiko für das Unternehmen darstellt. Durch Ende-zu-Ende Automatisierung der erforderlichen Analytik und Vorpriorisierung in Richtung Fachexperten wird dieses Verfahren insgesamt skalierbar.

Und es funktioniert! Mit derartiger Risikosensorik konnte eine weltweit führende Bank ein bislang unbekanntes Betrügernetzwerk identifizieren, eine führende deutsche Bank konnte eine Lücke im Hochrisikobereich ihres Kreditvergabeprozesses schließen, und einer Verwaltungseinheit des Bundes konnten problematische Beratungsstundensätze aufgezeigt werden.

Daher gilt für Entscheidungsträger, die unternehmerische Blechschäden und Schlimmeres vermeiden wollen: An jede Datenquelle gehört ein Risikosensor!

(Bildquelle: AdobeStock | 408000114 | Blue Planet Studio)