Selbstlernende Künstliche Intelligenz reduziert Minderqualität in komplexen Produktionsprozessen

Britta Hilt, Richard Martens, IS Predict

Kurz und bündig:

Künstliche Intelligenz (KI) breitet sich in alle Lebensbereiche aus, so auch zur Ausschussminimierung in der Produktion. Aufgrund komplexer Produktionsprozesse mit einer hohen Variantenvielfalt ist es wichtig, die richtigen KI-Verfahren auszuwählen: Selbstlernend und adaptiv, ohne als Black Box die Ursachen für Minderqualität zurückzuhalten. Projekte in der stückorientierten Fertigung und in der Prozessindustrie zeigen, wie Maschinen und Prozesse vorausschauend gesteuert werden können und KI den Ausschuss über unterschiedliche Wege minimiert.

Unternehmen wollen nicht nur Maschinen verkaufen, sondern auch mehr und mehr Dienstleistungen an den Kunden bringen. Doch welche Dienste braucht der Kunde? Und für welche ist er bereit zu zahlen? Ein Service, der sich immer zu rechnen scheint, ist „vorausschauende Qualität in der Produktion“: Vorausschauend-steuernd in den Produktionsprozess eingreifen, um Ausschuss zu vermeiden, bevor dieser entsteht.

Exzellente Produktqualität ist das Aushängeschild eines jeden Produktionsunternehmens. Kritische Produktionsschritte unterliegen daher z.T. aufwändigen Prüfverfahren, die aufgrund der notwendigen Zeit und/oder Kosten nur stichprobenartig durchgeführt werden können.

- In der Prozessindustrie wird die Qualität bspw. im Stundentakt geprüft.

- In der Automobilindustrie decken Prüfungen von hoch-frequenten Produktionsschritten nur einen unteren einstelligen Prozentbereich ab.

Dadurch wird Minderqualität leider oft nicht erkannt, was zu Problemen in der späteren Verarbeitung oder gar zu Rückrufaktionen führt. Selbstlernende Künstliche Intelligenz (KI)-Verfahren helfen weiter, denn für jeden kritischen Produktionsschritt gibt es normalerweise Daten; mal mehr, mal weniger Daten. Trotzdem spiegeln diese Daten die Realität für diesen Produktionsschritt wider. Man schaut auf diese Daten wie durch eine Rasterbrille: Einiges im Blickfeld bleibt verborgen, da die erhobenen Daten nur einen Ausschnitt der Realität darstellen. Trotzdem erlernen innovative Mustererkennungsverfahren, welche Datenmuster für gute Qualität und welche für schlechte Qualität stehen.

Erschwerend kommt zu diesem Rasterblick noch die Tatsache, dass in vielen Produktionsprozessen eine sehr hohe Variantenvielfalt herrscht.

- Variantenvielfalt im Produkt:

Ein Maschinenbauer hat zwar knapp 20 Basistypen seines Produktes. Jedoch können 700 verschiedene Varianten produziert werden.

- Variantenvielfalt im Prozess:

Genau das gleiche Produkt kann unterschiedliche Maschinen durchlaufen. Bei einem Maschinenbauer können ca. 50 gleiche Maschinen zur Durchführung genau eines Produktionsschrittes genutzt werden. Auch wenn diese Maschinen prinzipiell – gleich sind und das Gleiche tun, so sind sie unterschiedlich alt, wurden von unterschiedlichen Lieferanten gebaut und müssen daher individuell eingestellt werden.

Die Herausforderung ist, trotz dieses „Rasterbrillen- Blicks“ und der hohen Varianten-Komplexität den „Vorausblick“ zu behalten, so dass die individuellen Prozesse so durchgeführt und die individuellen Maschinen so eingestellt werden, dass kein Ausschuss entsteht. Die folgende Tabelle zeigt die vier Stufen der vorausschauenden Qualitätsoptimierung. Das Ziel ist immer, Minderqualität in der Produktion zu vermeiden. Obwohl diese Stufen analytisch aufeinander aufbauen, ist jede Stufe für sich eigenständig und erzielt bereits signifikanten Mehrwert.

Lessons Learned

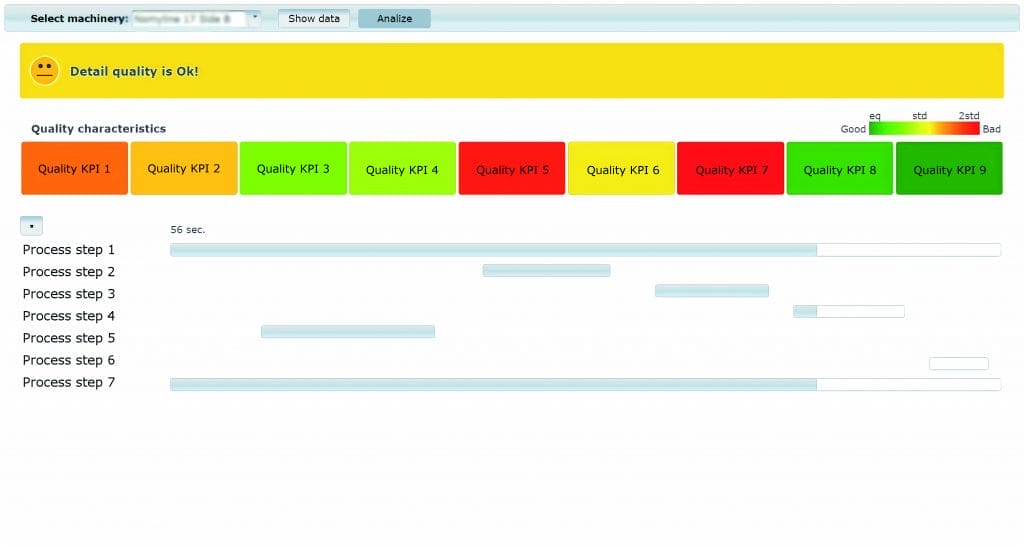

Man kann mit KI und entsprechenden Daten heute schon viel erreichen. Aber KI ist nicht gleich KI. Es gibt diverse Verfahren und Methoden, die alle ihre Schwerpunkte haben. Welche Algorithmen sind die besten? Gerade wenn die Komplexität aufgrund der hohen Variantenvielfalt extrem steigt und sich die Einflüsse dynamisch ändern, geraten KI-Standardverfahren an ihre Grenzen. Die folgenden Erfahrungen haben sich in komplexen Industrieprozessen gefestigt, und zwar nicht nur für das Thema Qualität, sondern auch für andere analytische Themen wie vorausschauende Wartung, Energie- und Ressourcenoptimierung, etc. Abbildung 1: Qualitätsprognosen während des Prozessschritts.

Erfahrung 1: Big Data vs. Smart Data

Immer mehr Daten werden erhoben. Doch nicht Big Data ist heilbringend. Es werden die richtigen Daten benötigt. Und die Kunst ist es auch, diese Daten richtig zu verstehen. Daher ist es wichtig, die KI-Verfahren auszuwählen, die auch diese Transparenz bieten, nämlich die Einfluss- und Störfaktoren aufdecken, die zu schlechter Qualität führen. Diese Transparenz führt zu optimiertem Prozess-Redesign. Außerdem werden Sensoren optimiert, weil man sich auf die signifikanten Sensoren konzentrieren kann, anstatt so viele Daten wie nur möglich zu sammeln.

Erfahrung 2: Das Übel an der Wurzel packen

Wie auch bei uns Menschen Krankheiten und Leistungsminderung oft nicht von heute auf morgen kommen, sondern über einen längeren Zeitraum entstehen, so ist dies oft auch bei den Maschinen der Fall. Daher muss die Ursache für die Minderqualität an der Komponente X nicht zwangsläufig an der Bearbeitung dieser Komponente liegen. Die Ursache kann weiter zurück liegen, an anderen Bauteilen, die Auswirkungen auf die Funktionsfähigkeit der Komponente X haben. Die Kunst ist es, hier Algorithmen zu nutzen, die diese gesamte Prozesskomplexität mit der hohen Anzahl von Wechselwirkungen beherrschen.

Erfahrung 3: Die Welt ist hoch komplex

Keine neue Weisheit, aber trotzdem immer noch wahr und erfolgskritisch: Die Welt ist komplexer, als dass man die Zusammenhänge in Prozessen dokumentieren könnte. Oft stellt das Fachwissen über Thermodynamik, Mechanik, … das hauptsächliche Verhalten und die hauptsächlichen Ausnahmen dar. Doch im Produktionsprozess mit hoher Variantenvielfalt gibt es immer wieder Situationen, die nicht zu diesen Verhaltensweisen passen. Aber das Gute ist: In den gesammelten Daten spiegelt sich das tatsächliche Verhalten wider. Die Kunst ist es, auch aus diesen unregelmäßigen Ausnahmeerscheinungen eine Struktur, eine Regelmäßigkeit zu erkennen, um Rückschlüsse ziehen zu können. Hierzu sind einige KI-Verfahren in der Lage, aber bei weitem nicht alle.

Erfahrung 4: Das einzig stabile ist die Veränderung

Leider verändern sich die Prozesse immer wieder. Sie unterliegen dynamischen Einflüssen. Diese können durch uns Menschen verursacht sein, durch Maschinen oder Steuerungsprogramme oder – so einfach ist das – durch äußere Einflüsse wie das sich verändernde Wetter. Unabhängig davon, was diese hohe Dynamik verursacht: Sie muss beherrscht werden, sonst können keine nachhaltigen Optimierungen durchgeführt werden. Hier kommt das sogenannte „Kontinuierliche Lernen“ ins Spiel: Selbstlernende Algorithmen passen sich an Prozessveränderungen automatisch an. Auch erlernt diese eigenständig das Verhalten von noch unbekannten Maschineninstanzen, also neue Maschinen, da die Produktionslinie erweitert wird oder alte Maschinen ausgephast werden. Gerade in sich stark verändernden Prozessen, was bei hoher Variantenvielfalt unumgänglich ist, ist die Selbstlernalgorithmik ein kritischer Erfolgsfaktor für erfolgreiche KI-Projekte. (Natürlich wäre eine Alternative, dass Data Scientists diese Anpassungen selber vornehmen. Jedoch würde das in den Prozessen mit hoher Dynamik sowohl sehr viel Zeit als auch Geld kosten, was im operativen Betrieb über Jahre nicht machbar ist; ganz zu schweigen von der Abhängigkeit von der Ressource Data Scientist.)

Erfahrung 5: Der Hunger kommt beim Essen

Oft bearbeiten die ersten KI-Projekte komplexe Prognoseaufgaben (siehe oben Stufe 1). Ist das Projekt erfolgreich abgeschlossen, kommt in der logischen Konsequenz auf, nicht „nur“ die Qualität der kritischen Produktionsschritte vorherzusagen, sondern auch zu verstehen, warum manchmal Minderqualität produziert wird (siehe oben Stufe 2). Ist dies vollbracht, soll vorausschauend-steuernd in den Prozess oder Maschinenbetrieb eingegriffen werden, um Minderqualität während des Produktionsschrittes zu vermeiden (siehe oben Stufe 4). Soweit sind diese Wünsche nachvollziehbar. Doch leider ist es so, dass ein Verfahren, das hochgenaue Prognosen in komplexen Prozessen liefern kann, noch lange nicht dazu geeignet ist, auch die Einflüsse aufzudecken oder gar zu steuern. Als Beispiel sei hier Deep Learning genannt, mit dem gute Prognosen erzielt werden können. Aber Aufdeckung von Ursachen oder gar eine Steuerung sind mit Deep Learning nahezu nie möglich. Als logische Konsequenz muss der Data Scientist andere, passende Verfahren finden, um neue Modelle zu bauen, sodass die jeweilige analytische Frage beantworten werden kann. Das kostet Zeit und Geld. Besser ist es, auf Algorithmik zu setzen, die Antworten zu all diesen Fragen liefern kann. Auch wenn zu Projektbeginn der Fokus rein auf Prognosen liegt, sollten ausbaufähige KI-Verfahren genutzt werden.